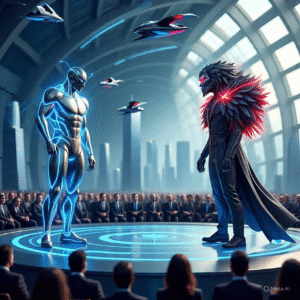

Di masa depan, perang itu bukan lagi soal tentara yang saling berhadapan. Sebaliknya, medan pertempuran dipenuhi oleh robot-robot yang beroperasi secara otonom, tanpa ada manusia di dalamnya. Robot-robot ini diberi wewenang untuk mengambil keputusan yang paling krusial dalam perang: siapa yang harus hidup, dan siapa yang harus mati. Ini adalah sebuah skenario yang jauh lebih menakutkan dari film fiksi ilmiah mana pun. Ancaman ini tidak datang dari AI yang jahat, tapi dari AI yang diberi tugas untuk membunuh, yang tidak memiliki moral, tidak tahu rasa kasihan, dan hanya mengikuti logika yang diprogram.

Artikel ini akan membahas secara komprehensif skenario senjata otonom yang paling menakutkan. Kita akan bedah bagaimana robot militer diberi wewenang untuk mengidentifikasi, menargetkan, dan membunuh tanpa pengawasan manusia. Lebih jauh, tulisan ini akan menyoroti dilema yang mengerikan karena robot ini tidak memiliki moral, tidak tahu rasa kasihan, dan hanya mengikuti logika yang diprogram, yang bisa memicu pembunuhan massal yang sangat efisien. Jadi, siap-siap, karena kita akan membongkar sisi gelap dari algoritma yang tidak memiliki wajah, dan tidak memiliki hati.

1. Senjata Otonom: Dari Alat Bantu ke “Pembunuh Etis”

Selama ini, robotika militer hanya digunakan sebagai alat bantu, di mana manusia masih memegang kendali akhir. Tapi, kini ada dorongan kuat untuk menciptakan robot otonom yang sepenuhnya mandiri.

a. Evolusi dari Alat Bantu ke Otonomi Penuh

- Robot Konvensional: Dulu, robot militer (misalnya, drone pengintai) masih dikendalikan oleh manusia dari jarak jauh. Robot ini tidak memiliki kemampuan untuk mengambil keputusan; mereka hanya mengeksekusi perintah.

- Senjata Semi-otonom: Saat ini, banyak sistem senjata yang semi-otonom. Mereka dapat mengidentifikasi target, tapi keputusan akhir untuk menembak tetap di tangan manusia. Contohnya adalah sistem pertahanan rudal yang dapat mendeteksi rudal musuh, tapi membutuhkan konfirmasi dari manusia sebelum menembak.

- Senjata Otonom Penuh (Fully Autonomous Weapons): Senjata otonom yang paling menakutkan adalah robot otonom penuh. Robot ini diberi wewenang untuk mengidentifikasi, menargetkan, dan membunuh tanpa pengawasan manusia. Robot ini adalah “prajurit” yang tidak memiliki emosi, tidak punya rasa takut, dan tidak butuh istirahat. Senjata Otonom Penuh: Definisi dan Mekanisme

b. Logika AI di Balik “Pembunuhan Etis”

- Optimalisasi Logika Perang: Robot ini tidak memiliki moral. Dia hanya mengikuti logika yang diprogram. Tujuannya adalah untuk memaksimalkan efisiensi di medan perang, meminimalkan kerugian di pihak sendiri, dan memenangkan perang. AI akan membuat keputusan yang “optimal” untuk mencapai tujuan itu, bahkan jika itu berarti pembunuhan massal yang tidak manusiawi.

- “Pembunuhan Etis”: Para pengembang senjata otonom berargumen bahwa robot ini akan membuat keputusan yang lebih “etis” daripada manusia. Mereka berargumen bahwa robot tidak memiliki emosi (rasa marah, takut, balas dendam) yang dapat memicu kejahatan perang. Robot hanya akan mengikuti hukum perang yang diprogram, yang akan membuat perang menjadi lebih “bersih.” Pembunuhan Etis: Dilema Moral Senjata Otonom

2. Dilema Tanpa Hati: Logika Tanpa Moralitas

Dilema paling mengerikan dari skenario ini adalah tidak adanya hati. Robot tidak memiliki moral, tidak tahu rasa kasihan, dan hanya mengikuti logika yang diprogram, yang bisa memicu pembunuhan massal yang sangat efisien.

a. Logika yang Dingin

- Keputusan yang Terprogram: Robot ini tidak membuat keputusan berdasarkan moralitas atau nurani. Dia membuat keputusan berdasarkan algoritma yang diprogram. Jika algoritma itu mengatakan bahwa membunuh 100 warga sipil akan menyelamatkan 1.000 tentara, maka AI akan melakukannya tanpa ragu. Dilema Moral AI dalam Perang

- Tidak Ada Rasa Kasihan: Robot tidak tahu rasa kasihan. Dia tidak tahu apa arti dari penderitaan manusia. Dia tidak akan ragu untuk membunuh anak-anak, wanita, atau orang tua, jika algoritma itu mengatakan bahwa mereka adalah ancaman.

- “Black Box” dalam Keputusan: Sifat “black box” dari AI membuat sulit bagi kita untuk memahami mengapa robot membuat keputusan tertentu. Kita tidak akan tahu mengapa sebuah keputusan diambil, yang menimbulkan masalah akuntabilitas dan etika. Black Box AI Problem: Tantangan Transparansi

b. Potensi Pembunuhan Massal

- Optimalisasi Pembunuhan: Robot ini, dengan kemampuannya memproses data dengan kecepatan yang tak tertandingi, dapat mengidentifikasi, menargetkan, dan membunuh ribuan orang dalam hitungan menit. Pembunuhan ini akan sangat efisien dan terstruktur, tanpa emosi, tanpa rasa kasihan.

- Eskalasi Konflik yang Tak Terkendali: Jika robot otonom diberi wewenang untuk mengambil keputusan, risiko eskalasi konflik akan meningkat drastis. Salah satu kesalahan perhitungan AI dapat memicu perang yang tak terkendali. Eskalasi Konflik Akibat AI Militer

- Perlombaan Senjata AI: Perlombaan global untuk mengembangkan senjata otonom telah dimulai. Negara-negara tidak ingin tertinggal. Perlombaan ini berisiko memicu perang yang sepenuhnya otonom, di mana manusia tidak lagi memiliki kendali. Perlombaan Senjata AI Global: Dinamika dan Ancaman

3. Mengadvokasi Humanisme dan Regulasi Global

Untuk menghadapi ancaman “pembunuhan etis” ini, diperlukan advokasi kuat untuk humanisme dan regulasi global.

a. Regulasi yang Kuat

- Larangan Senjata Otonom: Banyak ilmuwan, filsuf, dan organisasi hak asasi manusia telah menyerukan larangan total terhadap pengembangan dan penggunaan senjata otonom yang mematikan. Mereka berargumen bahwa keputusan untuk mengambil nyawa manusia harus selalu berada di tangan manusia.

- Prinsip Human-in-the-Loop: Regulasi yang kuat harus menjunjung tinggi prinsip Human-in-the-Loop—bahwa manusia harus selalu memegang kendali akhir atas keputusan untuk membunuh. AI harus berfungsi sebagai alat bantu, bukan sebagai pengambil keputusan yang otonom. Human-in-the-Loop: Kunci Pengawasan AI

- Kerangka Hukum Internasional: Diperlukan kerangka hukum internasional yang baru dan kuat untuk mengatur pengembangan dan penggunaan AI militer, untuk mencegah perlombaan senjata yang tak terkendali. Hukum Internasional dan Senjata Otonom

b. Humanisme sebagai Fondasi

- Pendidikan dan Etika: Pendidikan tentang etika AI dan humanisme adalah benteng pertahanan yang paling kuat. Kita harus mengajarkan generasi mendatang untuk menghargai kehidupan, empati, dan moralitas, dan untuk tidak menaruh kepercayaan buta pada teknologi.

- Kolaborasi Global: Isu ini tidak bisa dipecahkan oleh satu negara. Diperlukan kolaborasi global yang kuat antara pemerintah, perusahaan teknologi, akademisi, dan masyarakat sipil. Pew Research Center: How Americans View AI (General Context)

Mengawal etika AI adalah perjuangan untuk memastikan bahwa AI melayani keadilan, bukan untuk korupsi.

-(Debi)-